これ、生成AIでなんとかならないの?

生成AIを自社の問い合わせ対応に適用するにはどうすればいいのか...

社内情報を元に質問応答を行う生成AIチャットボット「たまちゃん」を開発して、2024年3月から運用を開始しました。

はじめに

「毎日、問い合わせ対応に追われて、自分の仕事が進まない...」

社員やお客様からの様々な問い合わせに対応していると、あっという間に時間が過ぎてしまいますよね。「もし問い合わせ対応をAIが代わりにやってくれたら...」なんて、一度は考えたことがあるのではないでしょうか?

近年、そんな私たちの願いを叶えてくれるかもしれない「生成AI」が、目覚ましい進化を遂げています。文章作成、画像生成、翻訳といった幅広い分野での活用が広がる中で、企業においてはその導入と活用方法が重要なテーマとなっています。

私たちも、生成AIの可能性に注目し、積極的にその活用を進めています。その取り組みの一つとして、社内の情報を検索して、質問に答えてくれる頼れるチャットボット「たまちゃん」を開発・運用しています。(なお、コラム「生成AI導入初期の取り組み」では、安全に生成AIと対話できる社内向けツール「Slap4」についてもご紹介しています。)

本記事では、たまちゃんの仕組み、管理者向けの機能、構築・運用のポイントなどを紹介します。たまちゃんの取り組みが、生成AI導入や活用を検討する上で、少しでも参考になれば幸いです。

たまちゃんとは

たまちゃんは、社内情報を基に生成AIを使って質問応答を行うチャットボットです。弊社でコミュニケーションツールとして利用しているSlackから気軽に社内情報に関する問い合わせを行うことができます。

弊社のSlackワークスペース上で、ユーザーが「@たまちゃん」とメンションを付けて質問することで、たまちゃんとの対話が可能になります。

図1の利用イメージでは、弊社の名刺準備の手続きをたまちゃんが案内しています。 通常、生成AIはインターネット上のデータを元に学習をしているため、弊社の社内情報は知らないはずです。では、たまちゃんはどのようにして弊社の社内情報を元に回答したのでしょうか?

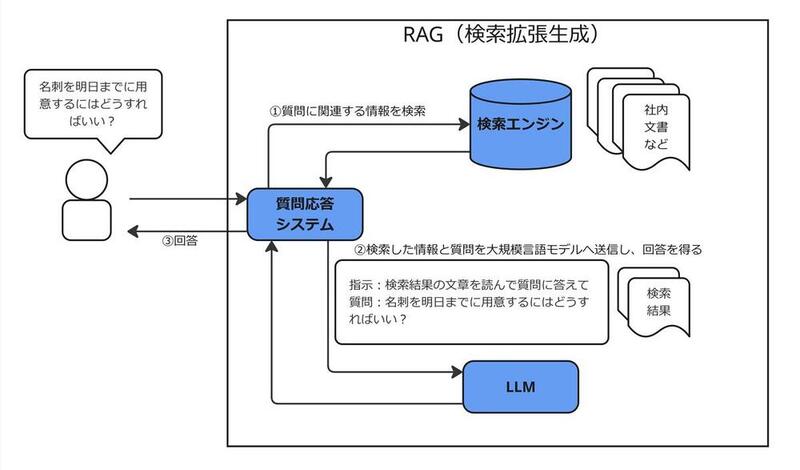

RAG(検索拡張生成)とは

たまちゃんがどのようにして社内情報を元に回答しているのか、その仕組みを見ていきましょう。

たまちゃんは、「RAG」という技術を利用しています。 RAGはRetrieval Augmented Generationの略で、日本語では検索拡張生成とも呼ばれます。

RAGは、ユーザーからの質問に関連する文章を検索し、その文章を大規模言語モデル(以降、LLMと表記)への入力(プロンプト)に加えて渡す仕組みです。

の概要)

LLMは、様々なタスクをこなすことができる非常に優れたAIですが、学習データに基づいて回答を生成するため、学習した範囲外のことはできません。つまり、LLMが学習していない最新の情報や、特定の企業内の情報といった固有の情報については、LLM単体では回答することができません。

そこで、RAGの技術を用いて、LLMが持っている知識を検索によって補完することで、LLM単体では知りえない情報についても回答できるようになります。

たまちゃんはRAGの導入により、弊社のイントラサイトや業務マニュアルといった社内情報に基づいて、ユーザーからの質問に対して回答を行うことができる仕組みになっています。

システム構成

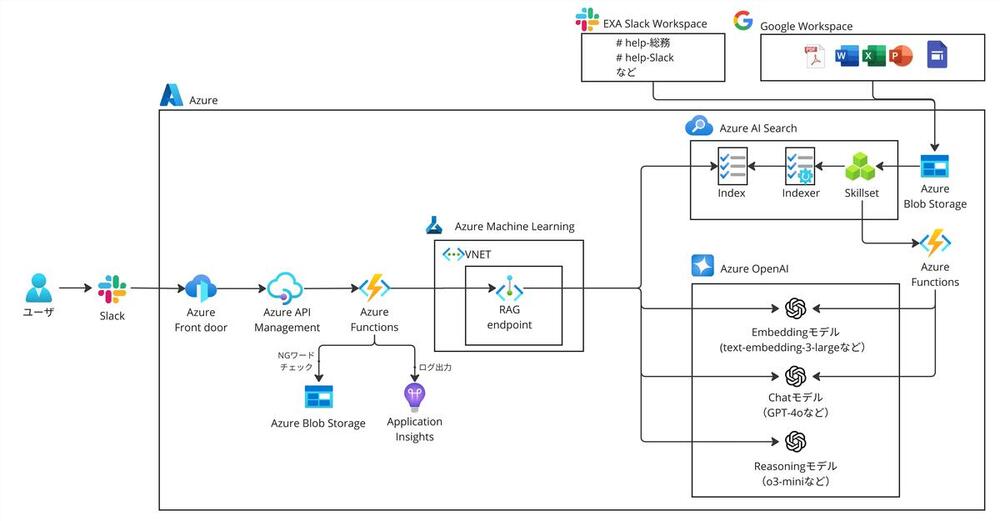

たまちゃんのシステム構成を図3に示します。コラム「生成AI導入初期の取り組み」でご紹介した「Slap4」と同様に、たまちゃんには以下の特徴があります。

1. セキュリティを考慮したLLMの利用

-

入力データを学習しないAzure OpenAI Serviceを採用しています。

-

Azure OpenAI Serviceに備わっているフィルター機能で、有害なコンテンツの入出力を検出して防止します。

-

Azure OpenAI Serviceのフィルター機能で対応しきれない社内の機密情報のチェックなどに関しては、独自にNGワードによるチェック機能を実装しています。

-

個人情報に関する質問には答えないようにプロンプトで制御しています。

2. ログ取得と分析

-

ユーザーの利用回数や利用用途、定着度合いなどのデータを取得しています。

3. 会話履歴を利用したチャット

-

Slackのスレッド機能を活用し、同一スレッド内で行った会話の履歴を使いながらLLMと対話することができます。

弊社ではSlackのほかにGoogleワークスペースを利用しているため、たまちゃんの情報の取得元はSlack、Googleドライブ、Googleサイトの3種類としています。各情報源から日次で情報を取得し、検索エンジンであるAzure AI Searchに登録/更新を行っています。

管理者向け機能

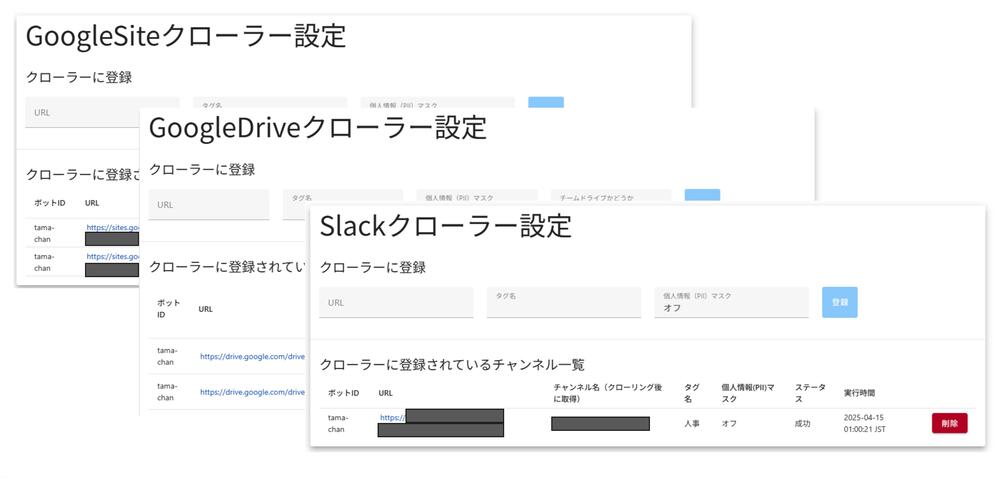

たまちゃんには、現在5つの部署の情報を登録しています。たまちゃんが常に最新かつ正確な情報を提供し続けるためには、実際に情報を管理する各部署の担当者による継続的なメンテナンスが不可欠です。そこで、各部署の担当者が容易に運用管理できるよう、専用のWebアプリケーションを開発しました。

主な機能は以下の通りです。

コンテンツ管理機能

各部署の担当者は、管理画面から情報源のURLを指定するだけで、たまちゃんに学習させる情報を簡単に登録・更新できます。現在、社内ポータル(Googleサイト)、マニュアル等が格納されたフォルダ(Googleドライブ)、質問応答用チャンネル(Slack)に対応しています。この機能により、担当者は常に最新かつ正確な情報をたまちゃんに反映させることができ、新制度や業務プロセスの変更などにも迅速に対応可能です。

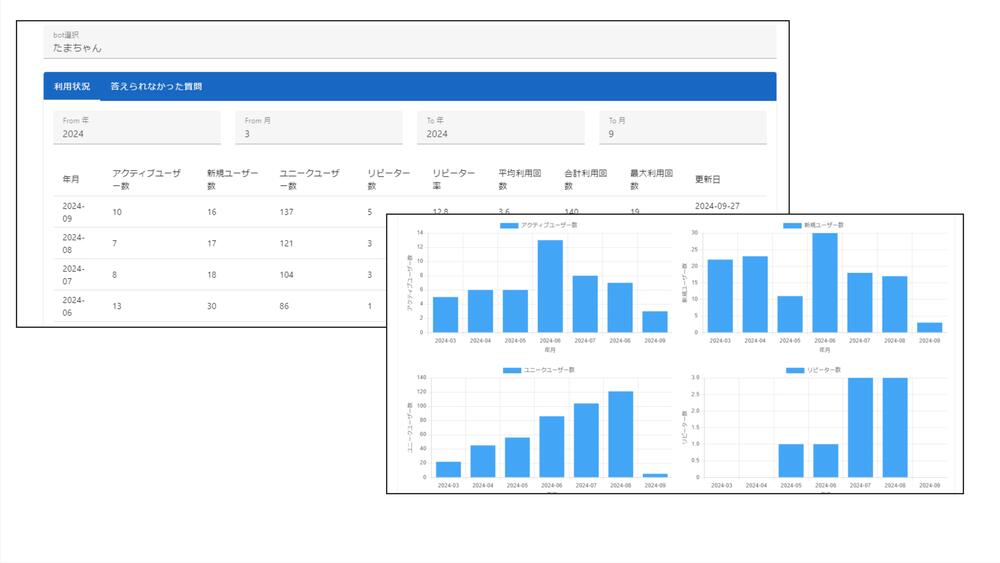

利用状況の可視化機能

コラム「生成AI導入初期の取り組み」で紹介した「Slap4」と同様に、たまちゃんに関しても月ごとの利用状況を表示する機能を実装し、改善に役立てています。利用状況の可視化機能では、アクティブユーザー数、新規ユーザー数、リピーター数、平均利用回数などを集計し、グラフで表示しています。

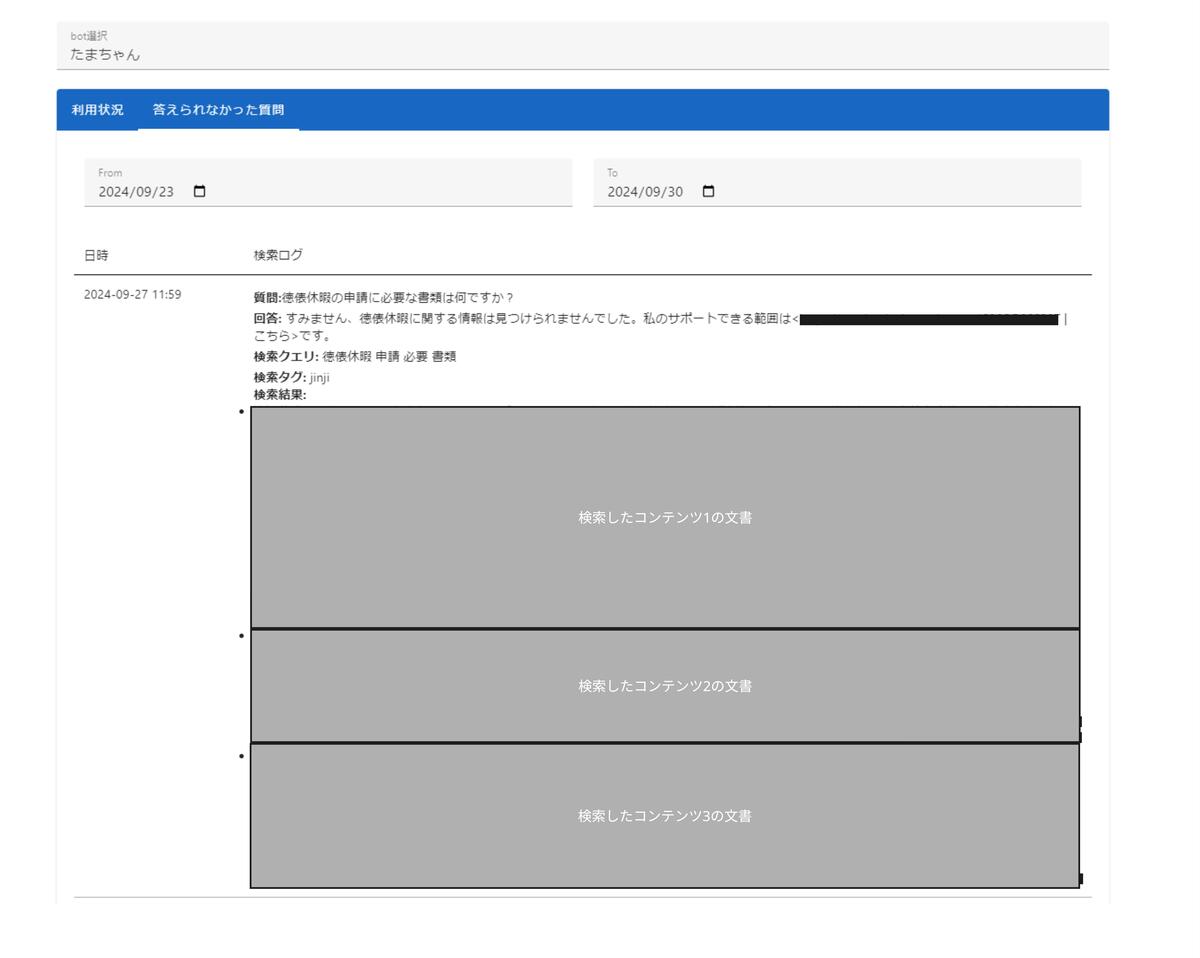

RAGのログ確認機能

たまちゃんは社内情報に基づいて回答を生成しますが、時にはユーザーが期待する回答を返せないこともあります。その原因を分析し、登録コンテンツを改善していくために、「RAGのログ確認機能」を実装しました。

たまちゃんが質問にうまく答えられない場合、その原因は主に次の2つのパターンに分けられます。

原因1. 回答に必要な情報が登録されていない:

たまちゃんは登録された社内コンテンツを知識源としています。そのため、質問に関連する情報がそもそもたまちゃんに登録されていなければ、回答を生成することはできません。この場合、各部署の担当者は新たにコンテンツを登録する必要があります。

原因2. 情報は登録されているが、うまく回答に結びつけられない:

必要な情報は登録されているものの、検索時に見つけられない、コンテンツ内の文書がLLMにとっては理解しにくい、質問の文章と微妙に表現が異なる、といった理由で適切な回答に結びつかないことがあります。

RAGログ確認機能を使うと、ユーザーからの質問に対し、たまちゃんがどの情報を参照しようとしたのか、そしてどのようなプロセスを経て回答生成に至ったのか(あるいは至らなかったのか)を確認できます。

各部署の担当者はこのログを見ることで、「情報が足りないのか」「コンテンツの書き方を工夫する必要があるのか」といった具体的な原因分析を行うことができます。もし情報が登録されているのに回答できなかった場合は、コンテンツ内の言葉遣いをより平易なものに変えたり、関連キーワードを追加したりといった修正を加えることで、回答精度が向上する可能性があります。実際、サイト内にたまちゃんが検索しやすいようにキーワードを埋め込んだことで回答できるようになった例もありました。

このように、RAGログ確認機能は、各部署の担当者自身が主体となって「たまちゃん」の回答品質を高めるための試行錯誤を支援するツールです。この機能を通じて、各部門の担当者がそれぞれの専門知識を活かし、たまちゃんをより頼れるアシスタントへと育てていくことを目指しています。

たまちゃん構築・運用におけるポイント:AIとの上手な付き合い方

たまちゃんを構築・運用する上で、特に注意を払った点がいくつかあります。それは、生成AI特有の課題である「ハルシネーション」への対策と、利用者の方々との認識合わせです。

1. ハルシネーション対策:事実に基づいた回答を目指して

生成AIは時に、事実に基づかないもっともらしい情報(ハルシネーション)を生成してしまうことがあります。社内情報という正確性が求められる情報を扱うたまちゃんにとって、この対策は非常に重要です。

たまちゃんでは、RAGの仕組みを採用し、登録された社内コンテンツに基づいて回答を生成することで、ハルシネーションのリスクを低減しています。さらに、技術的な対策として、たまちゃんが回答を生成する際には、その根拠とした社内コンテンツのURLを必ず回答に含めて提示するようにしました(図1参照)。これにより、回答の出所が明確になり、利用者はいつでも元情報を参照することができます。

2. 利用者への周知

これらの技術的な対策を講じても、100%完璧な回答を常に保証することは困難です。参照すべき情報が見つけられない場合や、情報の解釈を誤る可能性もゼロではありません。そこで、利用者の方々にも以下の点についてご理解とご協力をお願いしています。

-

参照情報源の確認:たまちゃんは100%正しい回答をするわけではないということを前提として、たまちゃんが提示する参照情報のURLを確認することを推奨しています。これは回答の透明性を高めるだけでなく、利用者自身による「ファクトチェック」を可能にするための重要な仕組みです。回答内容に少しでも疑問を感じたら、必ず提示された情報源を確認することで、誤った情報による手戻りやトラブルを防ぐことができます。

-

質問の仕方も大切: AIから的確な回答を引き出すには、実は質問の仕方も重要です。たまちゃんをより効果的に活用いただくために、どのような質問が良いか、具体的な例を交えた簡単なガイドを作成し、社内で公開しています。

このように、たまちゃんの開発・運用においては、システム的な工夫だけでなく、利用者の方々とのコミュニケーションを通じて、AIの特性や限界を理解いただき、協力してAIを育てていくという視点を大切にしています。

おわりに

本記事では、社内情報に特化したAIアシスタント「たまちゃん」について、開発の背景から、RAGを用いた仕組み、各部署の担当者によるコンテンツ管理やログ確認機能、そしてハルシネーション対策を含む構築・運用上の工夫まで、幅広くご紹介しました。

たまちゃんの挑戦はまだ始まったばかりです。より多くの社員にとって真に「頼れるアシスタント」となるためには、その回答精度をさらに高めていく必要があります。

そこで次回のコラムでは、「たまちゃんの回答精度をどう測るのか?そして、どう改善していくのか?」という、AIアシスタント運用における核心的なテーマに迫ります。私たちが行っている精度の評価方法や、具体的な改善アプローチについてご紹介する予定ですので、ぜひご期待ください。

今回の「たまちゃん」の事例が、皆様の会社での生成AI活用の一助となれば幸いです。最後までお読みいただき、誠にありがとうございました。

たまちゃんの取り組みに関しては、弊社のTech資料としても公開しておりますので、ぜひ併せてご覧いただければと思います。

執筆者紹介

連載コラム:エクサの生成AIチャレンジ日記

本コラムでは、エクサ社内における生成AIの活用に向けた技術的な取り組みと、実際の業務適用事例をご紹介いたします。生成AIによる業務効率化や新たな価値創造のヒントとなれば幸いです。

関連コラム

関連ソリューション

関連事例

お問い合わせ

CONTACT

Webからのお問い合わせ

エクサの最新情報と

セミナー案内を

お届けします